Como o Front-End e o Back-End Estão se Integrando com a Arquitetura de Microservices

Tudo sobre o post

- 1. A Evolução da Integração: Do Monólito à Arquitetura Microservices

- 2. O Papel Crucial do API Gateway na Arquitetura Microservices

- 3. Padrões de Front-End para Consumir Microservices: BFF e Além

- 4. Desafios e Soluções na Comunicação Front-End/Back-End em Microservices

- 5. O Futuro da Colaboração: Como a Arquitetura Microservices Molda Equipes e Processos

O desenvolvimento de software moderno passou por transformações sísmicas nas últimas décadas. Saímos de aplicações monolíticas, onde front-end e back-end eram frequentemente acoplados de forma rígida, para um mundo distribuído e dinâmico. No epicentro dessa revolução está a Arquitetura Microservices, um paradigma que não apenas redefiniu a forma como construímos o back-end, mas também impactou profundamente a maneira como o front-end interage com a lógica de negócios e os dados. Compreender essa nova dinâmica de integração é crucial para qualquer equipa que busca construir aplicações escaláveis, resilientes e ágeis.

A transição para a Arquitetura Microservices não é apenas uma mudança técnica; é uma mudança cultural e organizacional. Ela exige novas formas de pensar sobre design de sistemas, comunicação entre equipas e estratégias de implantação. Para os desenvolvedores front-end, isso significa adaptar-se a um cenário onde não há mais um único ponto de entrada no back-end, mas sim uma constelação de serviços especializados. Para os desenvolvedores back-end, implica projetar APIs robustas e bem definidas que sirvam como contratos claros para os consumidores, incluindo as interfaces de utilizador. Este post explorará em detalhe como essa integração acontece, os desafios enfrentados e as soluções emergentes que moldam o futuro do desenvolvimento full-stack no contexto da Arquitetura Microservices. Vamos mergulhar nas camadas dessa interação complexa e descobrir como otimizar a colaboração entre front-end e back-end neste novo paradigma.

1. A Evolução da Integração: Do Monólito à Arquitetura Microservices

Para entender plenamente a integração atual entre front-end e back-end, é fundamental revisitar o passado. Durante muitos anos, o modelo dominante foi a arquitetura monolítica. Neste modelo, toda a aplicação – interface do utilizador (front-end), lógica de negócios e camada de acesso a dados (back-end) – era desenvolvida, implantada e escalada como uma única unidade coesa. A comunicação entre o front-end e o back-end era frequentemente direta, às vezes até dentro do mesmo processo ou através de chamadas de função relativamente simples dentro do mesmo codebase. Embora simples em conceito, essa abordagem apresentava desafios significativos à medida que as aplicações cresciam em complexidade e escala. A rigidez do monólito tornava as atualizações lentas e arriscadas, pois uma pequena alteração numa parte do sistema poderia impactar inadvertidamente outras áreas. A escalabilidade também era um problema; se apenas uma funcionalidade precisasse de mais recursos, toda a aplicação monolítica tinha de ser escalada, levando a um desperdício de recursos computacionais. Além disso, a tecnologia era frequentemente homogénea, limitando a capacidade das equipas de adotar ferramentas mais adequadas para tarefas específicas.

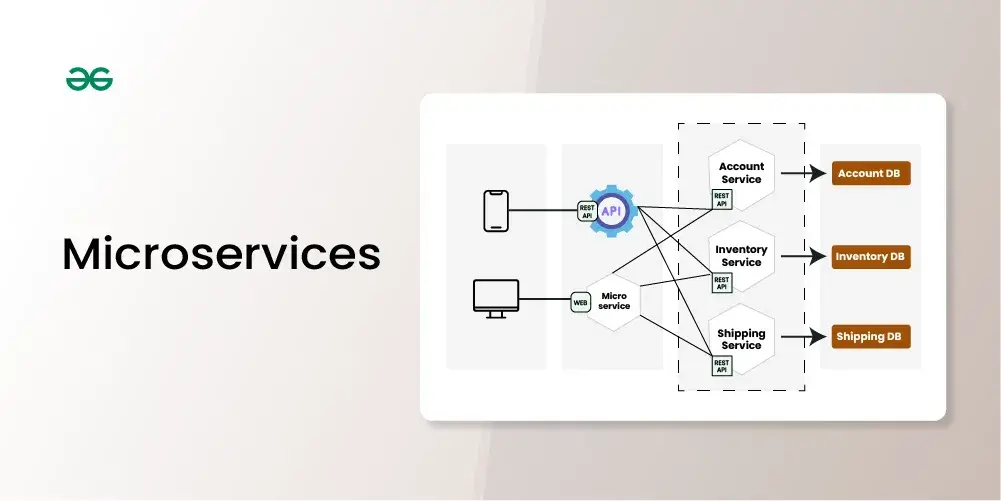

A emergência da Arquitetura Microservices surgiu como uma resposta direta a essas limitações. Este estilo arquitetónico estrutura uma aplicação como uma coleção de serviços pequenos, autónomos e fracamente acoplados, cada um focado numa capacidade de negócio específica. Cada microservice pode ser desenvolvido, implantado, escalado e gerido independentemente dos outros. Essa independência é a chave. No contexto da integração front-end/back-end, isso significa que o front-end já não se comunica com um único back-end gigante, mas potencialmente com múltiplos microservices, cada um expondo a sua própria API. Essa mudança fundamental introduz uma nova camada de complexidade na comunicação, mas oferece benefícios incomparáveis em termos de agilidade, resiliência, escalabilidade granular e liberdade tecnológica. A Arquitetura Microservices força uma separação mais clara de responsabilidades e define as APIs como contratos de primeira classe, essenciais para a interação entre os diferentes componentes do sistema, incluindo a interface do utilizador. A forma como o front-end consome esses múltiplos serviços tornou-se um ponto central de discussão e inovação.

A transição do monólito para a Arquitetura Microservices não foi instantânea, mas sim uma evolução impulsionada pela necessidade de entregar valor mais rapidamente e de construir sistemas mais robustos. Empresas pioneiras como Netflix, Amazon e Spotify popularizaram essa abordagem ao demonstrarem a sua eficácia na gestão de sistemas complexos em larga escala. O impacto na integração front-end/back-end foi imediato. Os desenvolvedores front-end precisaram de novas estratégias para orquestrar chamadas para múltiplos serviços, gerir estados distribuídos e lidar com a latência de rede inerente a um sistema distribuído. Por outro lado, os desenvolvedores back-end tiveram que se concentrar na criação de APIs bem projetadas, versionadas e documentadas, garantindo que fossem fáceis de consumir e resilientes a falhas. A Arquitetura Microservices não eliminou a necessidade de integração, mas transformou-a de uma comunicação interna e muitas vezes implícita num monólito, para uma comunicação externa, explícita e baseada em rede, exigindo novas ferramentas, padrões e uma mentalidade focada na colaboração e na definição clara de limites e contratos entre serviços. Esta evolução contínua a moldar as melhores práticas de desenvolvimento e a influenciar a forma como as equipas se organizam e colaboram.

Esta mudança paradigmática também teve um impacto significativo na experiência do desenvolvedor (Developer Experience – DX). No mundo monolítico, um desenvolvedor full-stack poderia, teoricamente, compreender e modificar todo o fluxo, desde a interface do utilizador até à base de dados, dentro de um único ambiente de desenvolvimento. Com a Arquitetura Microservices, a complexidade distribuída torna isso muito mais desafiador. O front-end pode precisar interagir com APIs de serviços desenvolvidos por equipas diferentes, usando tecnologias distintas e com ciclos de lançamento independentes. Isso exige ferramentas melhores para descoberta de serviços, mocks de API para desenvolvimento local e testes de integração mais sofisticados. A depuração de problemas que abrangem múltiplos serviços e a camada de front-end também se torna mais complexa, exigindo soluções de observabilidade robustas, como logging centralizado, métricas agregadas e tracing distribuído. A Arquitetura Microservices, portanto, não só mudou a forma como o front-end e o back-end se integram tecnicamente, mas também elevou a importância de práticas de engenharia sólidas, comunicação inter-equipas eficaz e um forte investimento em automação e ferramentas de suporte para gerir a complexidade inerente a sistemas distribuídos.

2. O Papel Crucial do API Gateway na Arquitetura Microservices

Numa Arquitetura Microservices, onde o back-end é composto por múltiplos serviços independentes, fazer com que o front-end se comunique diretamente com cada um deles seria impraticável e problemático. O front-end teria que conhecer a localização (endpoints) de cada microservice, lidar com diferentes protocolos de comunicação, gerir a autenticação e autorização para cada serviço individualmente e orquestrar múltiplas chamadas para compor uma única visão na interface do utilizador. Isso tornaria o código do front-end excessivamente complexo, frágil e fortemente acoplado à topologia interna do back-end. Qualquer refatoração ou alteração nos microservices do back-end poderia quebrar o front-end. É aqui que entra o padrão API Gateway, desempenhando um papel absolutamente crucial na facilitação da integração entre o front-end e o back-end distribuído. O API Gateway atua como um único ponto de entrada (Single Point of Entry – SPOE) para todas as requisições externas, incluindo aquelas originadas do front-end. Ele funciona como uma fachada, abstraindo a complexidade da Arquitetura Microservices subjacente.

As responsabilidades de um API Gateway são vastas e vitais para o bom funcionamento da integração. Primeiramente, ele realiza o roteamento de requisições: quando uma chamada chega do front-end, o API Gateway determina qual ou quais microservices devem lidar com essa requisição e encaminha-a adequadamente. Ele também pode realizar a agregação de respostas, combinando dados de múltiplos microservices numa única resposta otimizada para o front-end, reduzindo assim o número de idas e vindas pela rede (chattiness). Outras funções essenciais incluem: autenticação e autorização centralizadas, garantindo que apenas utilizadores e aplicações autorizadas possam aceder aos serviços; rate limiting e throttling, para proteger os serviços de back-end contra sobrecarga ou abuso; balanceamento de carga entre instâncias de um microservice; tradução de protocolos (por exemplo, expor uma API REST para o front-end enquanto se comunica com microservices via gRPC internamente); caching de respostas para melhorar o desempenho; e logging e monitorização centralizados das requisições. Ao centralizar estas preocupações transversais (cross-cutting concerns), o API Gateway simplifica enormemente tanto o desenvolvimento do front-end quanto o dos microservices individuais, que podem focar-se exclusivamente na sua lógica de negócio principal dentro da Arquitetura Microservices.

A implementação de um API Gateway pode variar. Pode ser um produto comercial (como Kong, Apigee, Tyk), um serviço gerido na nuvem (como AWS API Gateway, Azure API Management, Google Cloud API Gateway) ou até mesmo uma aplicação customizada desenvolvida internamente, utilizando frameworks como Spring Cloud Gateway ou Ocelot. A escolha depende das necessidades específicas do projeto, da escala, do orçamento e da expertise da equipa. No entanto, independentemente da tecnologia escolhida, o conceito permanece o mesmo: fornecer uma camada de abstração e controlo robusta entre os consumidores (front-end) e os provedores (microservices). É importante notar que, embora o API Gateway simplifique a vida do front-end, ele próprio pode tornar-se um componente crítico e um potencial gargalo se não for projetado, implementado e gerido corretamente. Estratégias como a implantação de múltiplas instâncias do Gateway, a utilização de padrões de design resilientes (como Circuit Breakers) e a monitorização contínua do seu desempenho são essenciais para mitigar esses riscos.

Além disso, a presença de um API Gateway facilita a evolução independente do front-end e dos microservices. O Gateway pode expor uma API estável para o front-end, mesmo que os microservices subjacentes sejam refatorados, divididos ou combinados. Isso é conseguido através da capacidade do Gateway de transformar requisições e respostas. Por exemplo, se um microservice muda o formato da sua resposta, o Gateway pode ser configurado para adaptar essa resposta ao formato esperado pelo front-end, evitando a necessidade de atualizar imediatamente a aplicação cliente. Esta capacidade de desacoplamento é um dos maiores benefícios da Arquitetura Microservices e o API Gateway é um facilitador chave para alcançar esse objetivo na camada de integração. Ele atua como um tradutor e um mediador, permitindo que as diferentes partes do sistema evoluam em ritmos diferentes, mas ainda assim comuniquem eficazmente. A gestão cuidadosa das versões das APIs expostas pelo Gateway também é crucial para suportar múltiplos clientes (diferentes versões de apps móveis, aplicações web) que podem não ser atualizados simultaneamente.

3. Padrões de Front-End para Consumir Microservices: BFF e Além

Embora o API Gateway resolva muitos problemas de comunicação entre o front-end e a Arquitetura Microservices, ele nem sempre é a solução perfeita para todas as necessidades de integração. Um API Gateway genérico, que serve múltiplos tipos de clientes (aplicações web, aplicações móveis nativas, dispositivos IoT, parceiros externos), pode não ser otimizado para as necessidades específicas de um determinado front-end. Uma aplicação móvel pode precisar de dados diferentes e num formato diferente de uma aplicação web desktop. Tentar criar uma API única no Gateway que sirva a todos pode levar a compromissos: ou a API torna-se demasiado genérica e ineficiente (exigindo que os clientes façam múltiplas chamadas ou filtrem grandes quantidades de dados), ou torna-se excessivamente complexa ao tentar acomodar todas as variações. Este desafio levou ao surgimento de padrões específicos para otimizar a interação entre um front-end particular e o back-end de microservices.

O padrão mais proeminente neste contexto é o Backend For Frontend (BFF). A ideia central do BFF é criar um serviço de back-end dedicado para cada tipo de experiência de front-end. Assim, poderia haver um BFF para a aplicação web, outro para a aplicação iOS e um terceiro para a aplicação Android. Cada BFF é responsável por interagir com os microservices de negócio necessários (muitas vezes através de um API Gateway mais genérico ou diretamente, dependendo da arquitetura) e agregar, filtrar e transformar os dados no formato exato que a sua interface de utilizador específica requer. O BFF atua como um adaptador ou mediador otimizado. Os benefícios são significativos: o código do front-end torna-se muito mais simples, pois recebe os dados exatamente como precisa; a performance melhora, pois o BFF pode otimizar as chamadas aos microservices e reduzir a quantidade de dados transferidos para o cliente; e cada equipa de front-end (ou equipa focada numa experiência de utilizador específica) pode possuir e evoluir o seu próprio BFF, dando-lhes mais autonomia e velocidade sem impactar outros clientes. O BFF é uma extensão lógica da filosofia da Arquitetura Microservices, aplicando o princípio de serviços focados e independentes mais perto da camada de apresentação.

A implementação de um BFF geralmente envolve a criação de uma API (normalmente REST ou GraphQL) no BFF que é consumida pelo front-end correspondente. A equipa responsável pelo front-end muitas vezes também é responsável pelo desenvolvimento e manutenção do seu BFF, promovendo um forte alinhamento entre a UI e a sua camada de dados imediata. No entanto, o padrão BFF não está isento de desvantagens. Ele introduz mais um serviço (ou vários) na arquitetura geral, aumentando a complexidade operacional e a necessidade de gestão de infraestrutura. Pode também haver alguma duplicação de lógica entre diferentes BFFs se não for gerida cuidadosamente (por exemplo, lógica de agregação de dados semelhante). É um trade-off: ganha-se otimização e autonomia para o front-end ao custo de mais componentes no sistema. É crucial avaliar se os benefícios de um BFF superam os custos adicionais de desenvolvimento e manutenção no contexto específico do projeto e da organização.

Para além do BFF, outras abordagens e tecnologias também influenciam a forma como o front-end consome dados numa Arquitetura Microservices. GraphQL, por exemplo, oferece uma alternativa interessante. Em vez de o back-end (seja um API Gateway ou um BFF) definir rigidamente a estrutura das respostas, GraphQL permite que o front-end especifique exatamente quais dados necessita numa única requisição. Isso pode mitigar os problemas de over-fetching (receber mais dados do que o necessário) e under-fetching (precisar fazer múltiplas chamadas para obter todos os dados) que podem ocorrer com APIs REST tradicionais. Um servidor GraphQL pode ser implementado como parte de um API Gateway, como um BFF, ou até mesmo como uma camada de agregação que se senta em frente aos microservices. Ele pode simplificar o desenvolvimento do front-end ao dar-lhe mais controlo sobre a busca de dados, embora introduza a sua própria complexidade no back-end para resolver eficientemente essas queries flexíveis. Outras tendências, como a adoção de Micro-Frontends, onde a própria interface do utilizador é decomposta em partes independentes desenvolvidas e implantadas por equipas diferentes, também se alinham com a filosofia da Arquitetura Microservices e exigem estratégias de integração cuidadosas, tanto entre os micro-frontends quanto entre cada micro-frontend e os serviços de back-end (frequentemente através de API Gateways ou BFFs).

4. Desafios e Soluções na Comunicação Front-End/Back-End em Microservices

Apesar dos benefícios, a comunicação entre o front-end e um back-end baseado em Arquitetura Microservices introduz um conjunto único de desafios que não eram tão proeminentes nas arquiteturas monolíticas. Um dos desafios mais imediatos é o aumento da latência de rede. Em vez de chamadas em processo ou locais, a comunicação agora depende de chamadas de rede entre o cliente, o API Gateway (ou BFF) e os vários microservices. Cada salto adiciona latência, o que pode impactar a responsividade da interface do utilizador. Além disso, a natureza distribuída do sistema aumenta a probabilidade de falhas parciais. Um ou mais microservices podem ficar indisponíveis ou lentos, e o sistema como um todo (incluindo o front-end) precisa ser resiliente a essas falhas. Lidar com a consistência de dados entre múltiplos microservices que podem ser atualizados numa única operação do utilizador (transações distribuídas) também é um problema complexo que pode afetar o que é exibido no front-end.

Para mitigar a latência, várias estratégias podem ser empregadas. O uso eficaz de caching, tanto no lado do cliente (navegador), quanto no API Gateway ou BFF, pode reduzir significativamente o número de chamadas aos serviços de back-end. A agregação de dados no API Gateway ou BFF, como mencionado anteriormente, minimiza o número de requisições que o front-end precisa fazer. O uso de protocolos de rede mais eficientes, como HTTP/2 (que permite multiplexação de requisições) ou gRPC (baseado em Protobuf e HTTP/2), pode também melhorar o desempenho da comunicação. Além disso, técnicas de design de UI assíncrono, onde a interface do utilizador não bloqueia enquanto espera por dados não essenciais, podem melhorar a percepção de desempenho. Para a resiliência, padrões como Circuit Breaker são fundamentais. Implementado no cliente, no API Gateway ou no BFF, o Circuit Breaker monitoriza as chamadas a um serviço específico e, se detetar um número excessivo de falhas, “abre o circuito”, interrompendo temporariamente as chamadas a esse serviço e retornando um erro ou um fallback imediatamente, evitando que o sistema fique preso à espera de um serviço indisponível e prevenindo falhas em cascata. Timeouts agressivos e retries inteligentes (com backoff exponencial) também são cruciais.

A gestão da consistência de dados em operações que abrangem múltiplos microservices é frequentemente abordada através do padrão Saga. Em vez de usar transações distribuídas ACID (que são difíceis de implementar e escalar em microservices), o padrão Saga coordena uma série de transações locais em cada microservice. Se uma etapa falhar, a Saga executa ações compensatórias para reverter as transações anteriores, garantindo a consistência eventual dos dados. Embora a lógica da Saga geralmente resida no back-end, o front-end precisa ser projetado para lidar com estados intermediários ou exibir informações que reflitam essa consistência eventual. Outro desafio importante é a gestão de contratos de API. Com múltiplos serviços evoluindo independentemente, garantir que as mudanças nas APIs dos microservices não quebrem o front-end (ou o API Gateway/BFF) é vital. Práticas como versionamento de API (no URI, cabeçalhos ou media type), testes de contrato (usando ferramentas como Pact), e uma comunicação clara entre as equipas de back-end e front-end são essenciais para manter a compatibilidade e a estabilidade da integração na Arquitetura Microservices.

Finalmente, a observabilidade torna-se muito mais crítica num sistema distribuído. Quando um erro ocorre ou o desempenho degrada, pode ser difícil identificar a causa raiz, pois a requisição pode ter atravessado múltiplos serviços. É essencial implementar: Logging Centralizado, onde logs de todos os componentes (front-end, API Gateway, BFFs, microservices) são agregados num local central para análise; Métricas, que fornecem dados quantitativos sobre o desempenho e a saúde de cada serviço (taxa de erro, latência, utilização de recursos); e Tracing Distribuído (usando ferramentas como Jaeger, Zipkin ou OpenTelemetry), que permite seguir uma única requisição através de todos os serviços que ela toca, visualizando o tempo gasto em cada etapa e identificando gargalos ou pontos de falha. Estas ferramentas de observabilidade são indispensáveis para depurar, otimizar e manter a saúde da complexa interação entre front-end e back-end numa Arquitetura Microservices. Sem elas, as equipas ficam “cegas” para o comportamento real do sistema em produção.

5. O Futuro da Colaboração: Como a Arquitetura Microservices Molda Equipes e Processos

A adoção da Arquitetura Microservices não é apenas uma decisão técnica; ela tem implicações profundas na forma como as equipas de desenvolvimento são estruturadas e como colaboram. A famosa Lei de Conway postula que “as organizações que projetam sistemas (…) estão constrangidas a produzir designs que são cópias das estruturas de comunicação dessas organizações”. No contexto dos microservices, isso muitas vezes leva a uma mudança de equipas organizadas por camada tecnológica (equipa de front-end, equipa de back-end, equipa de base de dados) para equipas multifuncionais (cross-functional teams) organizadas em torno de capacidades de negócio ou domínios específicos (verticais). Cada equipa possui de ponta a ponta um ou mais microservices relacionados a essa capacidade, e potencialmente também a fatia correspondente da interface do utilizador (especialmente se forem usados Micro-Frontends) ou, no mínimo, o BFF associado.

Essa estrutura de equipa promove maior autonomia e responsabilidade. A equipa tem o conhecimento e as habilidades necessárias (front-end, back-end, testes, operações) para construir, implantar e operar o seu serviço ou capacidade de forma independente. Isso acelera o desenvolvimento, pois reduz as dependências entre equipas. A comunicação necessária desloca-se das passagens de trabalho entre silos funcionais para a definição clara de contratos (APIs) entre as equipas donas dos serviços. A Arquitetura Microservices facilita este modelo “You Build It, You Run It”, onde a equipa que desenvolve o serviço também é responsável pela sua operação em produção, incentivando a construção de software mais robusto e resiliente. A colaboração entre desenvolvedores front-end e back-end dentro da mesma equipa vertical torna-se mais fluida e focada nos objetivos do negócio que a equipa serve.

Esta mudança organizacional exige também uma evolução nos processos de desenvolvimento e implantação. A Integração Contínua (CI) e a Entrega Contínua (CD) tornam-se ainda mais críticas. Cada microservice (e potencialmente cada micro-frontend ou BFF) deve ter o seu próprio pipeline de CI/CD automatizado, permitindo que as equipas implantem as suas alterações de forma independente, frequente e segura, sem a necessidade de grandes lançamentos coordenados (“release trains”) típicos dos monólitos. Isso requer um investimento significativo em automação de testes (unitários, de integração, de contrato, end-to-end) e em infraestrutura como código (IaC) para gerir os ambientes de forma consistente. A cultura DevOps, que enfatiza a colaboração entre desenvolvimento e operações, a automação e a monitorização, é um pré-requisito para o sucesso com a Arquitetura Microservices.

Olhando para o futuro, a integração entre front-end e back-end na Arquitetura Microservices continuará a evoluir. Tendências como Serverless (Funções como Serviço – FaaS) oferecem uma forma ainda mais granular de construir back-ends, onde a infraestrutura é totalmente abstraída, e podem ser usados como blocos de construção para microservices ou BFFs, com escalabilidade automática e pagamento por uso. A adoção crescente de Micro-Frontends estende os princípios dos microservices à camada de apresentação, permitindo que diferentes partes da UI sejam desenvolvidas e implantadas independentemente por equipas distintas, exigindo novas formas de composição no cliente ou no servidor (via BFFs ou API Gateways). Tecnologias de API como gRPC (para comunicação interna de alta performance) e GraphQL (para consultas flexíveis do front-end) continuarão a ganhar tração ao lado do REST. Ferramentas de orquestração de containers como Kubernetes tornaram-se o padrão de facto para gerir a complexidade da implantação e operação de microservices. Em última análise, o sucesso da integração front-end/back-end na Arquitetura Microservices dependerá não apenas da tecnologia, mas da capacidade das organizações de fomentar uma cultura de colaboração, comunicação clara, propriedade distribuída e investimento contínuo em automação e observabilidade.